«Дадата» экономит сотрудникам аналитического сервиса для застройщиков по 20 часов в месяц

Ребята две недели учили Excel исправлять ошибки в адресах новостроек и вторичек. А наш сервис «Стандартизация» справился с задачей за минуты — лучше самописных формул. Рассказываем, как теперь все работает.

Сервис аналитики для застройщиков собирает информацию о рынке жилья

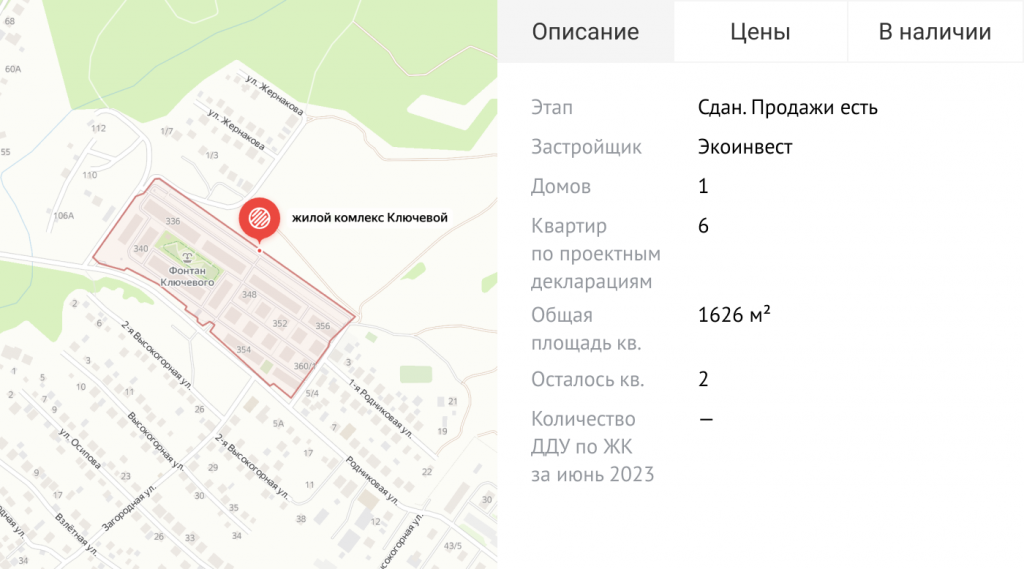

Компания-герой статьи — аналитический сервис для застройщиков в Новосибирске и Иркутске. Такой сервис собирает и показывает информацию о новостройках и вторичном жилье: дома на карте, площадь квартир, число нераспроданных квартир и этап строительства. Заодно анализирует сведения и предлагает застройщикам отчеты.

Благодаря информации от сервиса строительные компании правильно выбирают место стройки и тип жилья. В результате люди охотно покупают квартиры в новом доме, и застройщик зарабатывает.

Например, компания построила дом в районе с еще 20 новостройками. В каждой из них раскупили только 10% квартир. Предложение выше спроса, поэтому жилье в очередном здании покупать не будут. А если в новостройках раскупили все квартиры, то и в новом доме разберут.

Или компания построила дом с квартирами-студиями. А в других домах в районе — дорогие квартиры с большой площадью. Тогда есть риск, что новые квартиры не купят: целевая аудитория района не живет в студиях.

В исходных адресах вторичек полно ошибок

Раз в месяц сотрудники отдела аналитики сервиса актуализируют информацию: находят новые дома и вторичное жилье в продаже, агрегируют, проверяют, выкладывают на сайт.

Информацию о новостройках — первостепенную для сервиса — собирают операторы. Сведения берут на сайтах застройщиков, проверяют и вносят в базу в едином формате. Если на сайте недостаточно информации, оператор ищет ее где-то еще. Например, звонит в офис продаж застройщика.

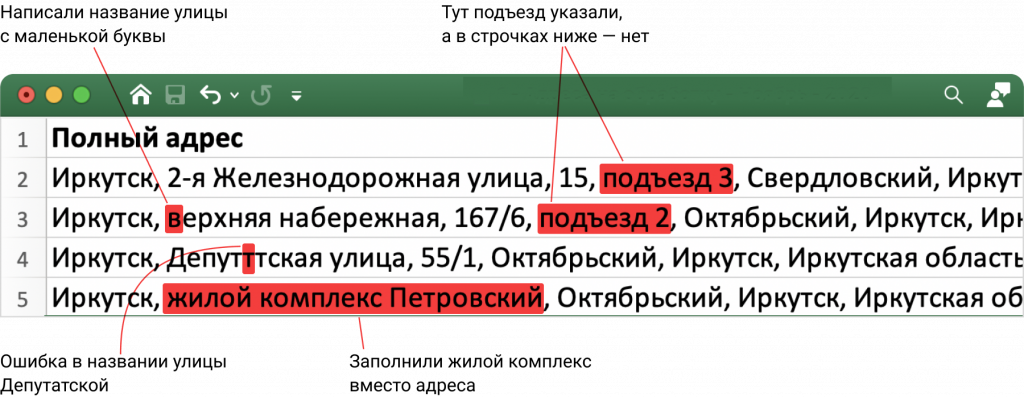

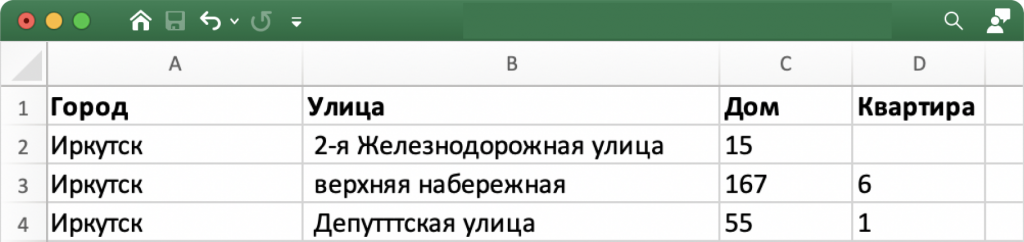

А вот информацию о вторичном жилье собирают автоматически из открытых источников в интернете — для скорости. Результат — excel-файл, в котором адреса не разделены по полям и записаны с ошибками. Так происходит, потому что их заполняют собственники квартир как попало:

Если из строчек базы не выделить город, улицу и номер дома, аналитики не смогут работать и делать выводы. А если не убрать из данных ошибки, застройщики перестанут доверять сервису.

Ошибки исправляли прямо в Excel. На это уходило по 20 часов каждый месяц

Когда ребята автоматически собирали данные о вторичках в новом городе, получали массив на 10 000 строк. Из него доставали правильные город, улицу и номер дома в отдельных полях. Это делали в четыре этапа.

1. Выделяли города. Адреса из одного населенного пункта записывают более или менее в одном формате, поэтому проще работать с каждым городом по отдельности.

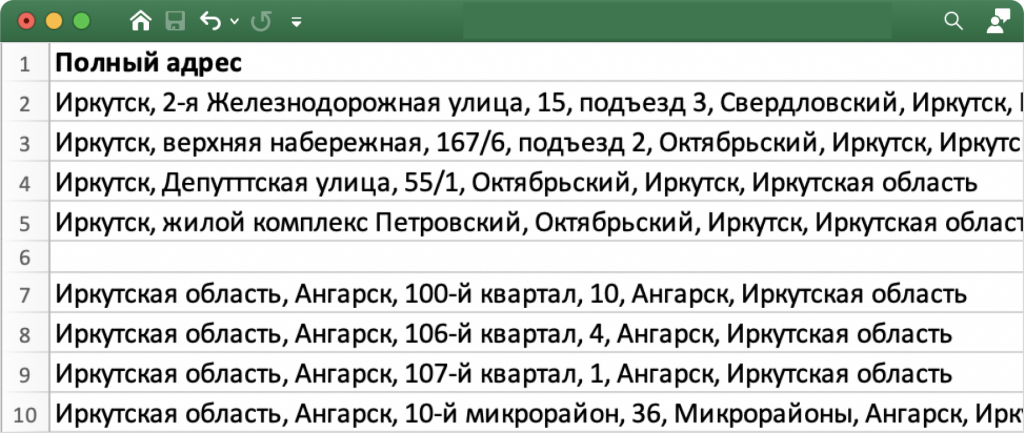

2. С помощью замен удаляли лишние данные. Например, у адресов в конце повторяется «Иркутск, Иркутская область». Это лишняя информация, поэтому ее заменяли на пустоту. И так до тех пор, пока не оставались город и улица с номером дома:

3. Делили один столбец на несколько, чтобы улица и номер дома были в отдельных полях. Без этого не исправить ошибки в названиях улиц — на следующем шаге.

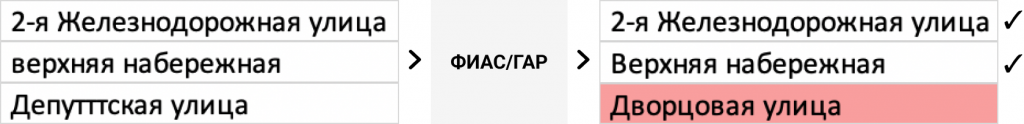

4. Убирали ошибки в названиях улиц. Для этого с помощью формул сопоставляли исходный список с ФИАС (ГАР) — справочником адресов налоговой службы.

Скажем, улицу записали с ошибкой — «Депутттская». В идеале формула сопоставит ее с похожей в базе ФИАС — Депутатской. На деле же формула часто ошибалась и сопоставляла Дупутатскую, например, с Дворцовой.

Ребята пытались автоматизировать процесс, но проблемы остались:

- формулы не давали идеального результата: пропускали ошибки, и аналитики исправляли их руками;

- базу ФИАС (ГАР), с которой сопоставляли улицы, обновляют дважды в неделю. Приходилось каждый раз скачивать актуальную версию;

- в будущем аналитикам требовались географические координаты домов, чтобы строить отчеты в Power BI. В массиве данных с информацией о вторичках координат не было. Поэтому в дополнение к Excel пришлось бы использовать сервис, который ищет широту и долготу домов. Это неудобно — проще работать с адресами в рамках одного инструмента.

«Дадата» исправляет ошибки за пару минут

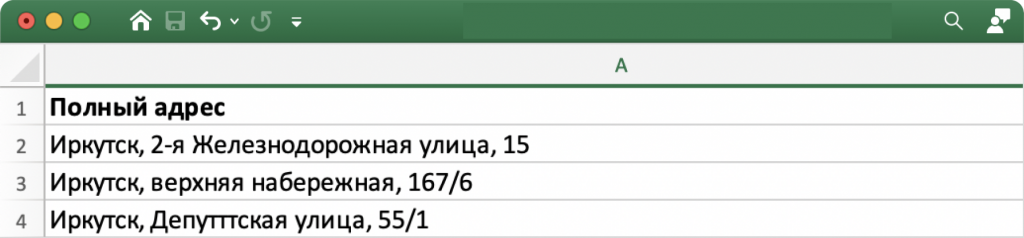

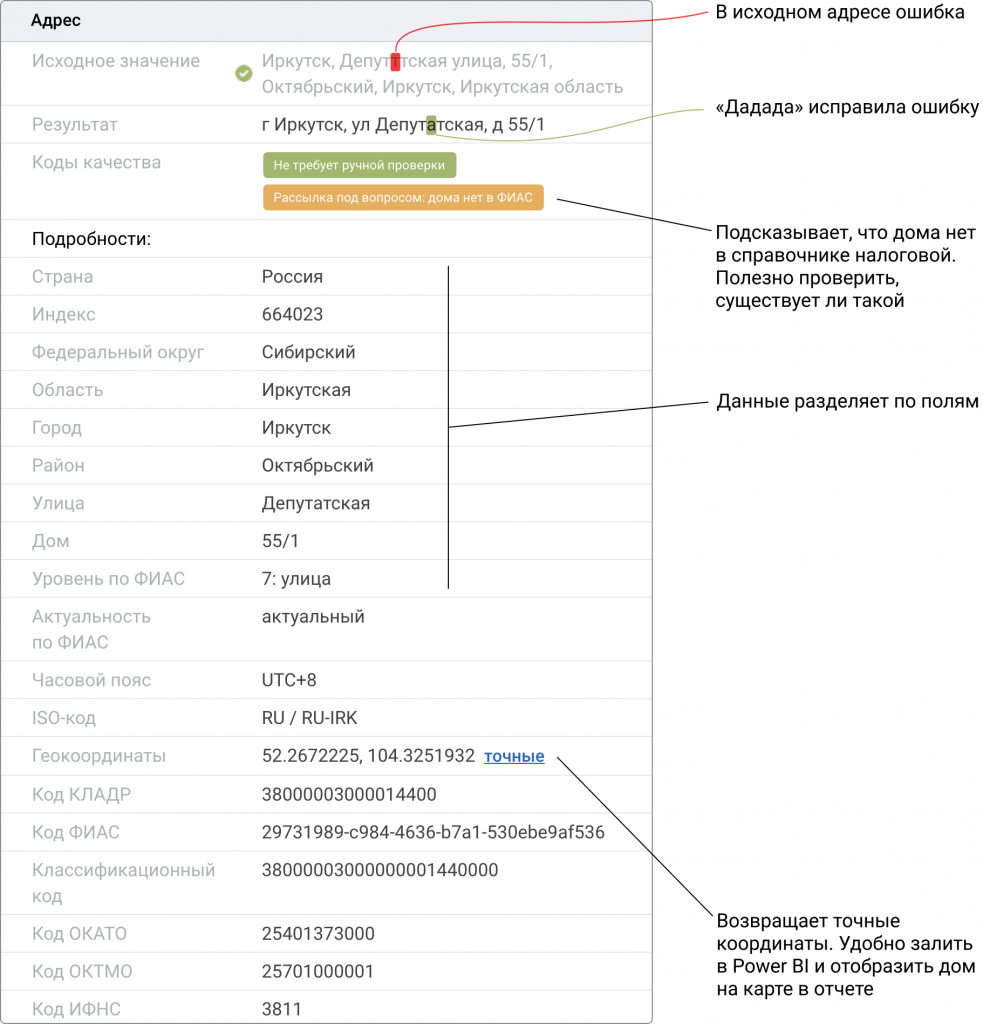

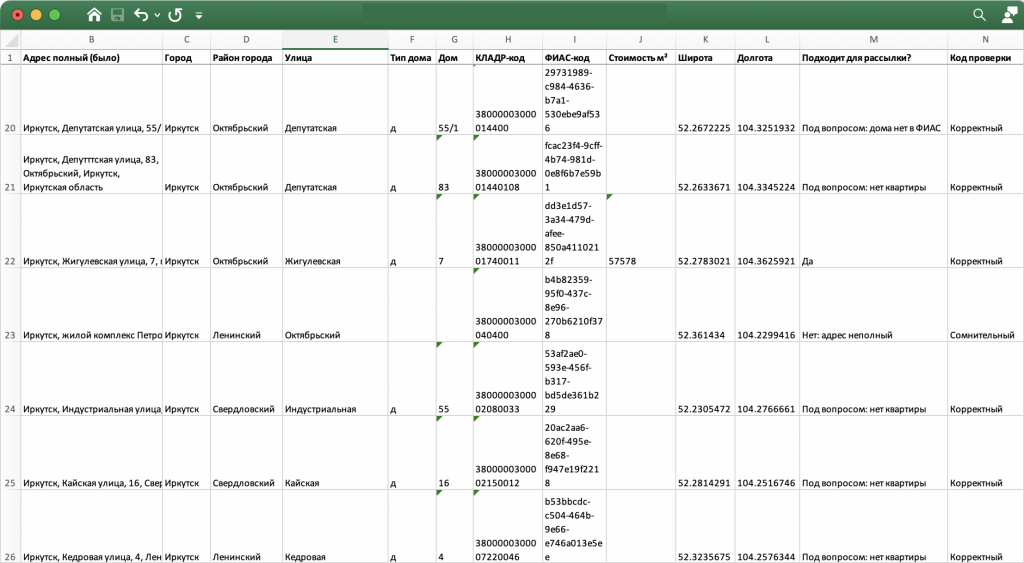

Чтобы сэкономить время, аналитики сервиса загружают исходный excel-файл с адресами вторичек в инструмент «Стандартизация» «Дадаты». Он автоматически разделяет 10 000 адресов на отдельные поля, проверяет улицы и дома по актуальной базе ФИАС (ГАР), исправляет ошибки и выдает координаты дома. Обработка такого файла стоит 1500 ₽.

На выходе получают excel-файл, с которым аналитикам удобно работать:

«Стандартизация» тоже ошибается, но таких случаев единицы. Точность сервиса — 99,99%: одна ошибка на 10 000 проверенных контактов. А если не уверен в разборе, сигнализирует аналитикам: мол, проверьте-ка адрес вручную. Для этого показывает специальные маркеры — коды качества.

«Стандартизация» готовит адреса, ФИО, телефоны и емейлы к бизнес-задачам

«Стандартизация» за раз очистит клиентскую базу, которую собирали годами. Или excel- и CSV-файлы, которые достались от подрядчиков. Базу в 10 000 строк сервис обработает за минуты: так быстрее, чем проверять данные вручную.

После очистки контакты сразу готовы к доставке заказов, рассылкам, обзвонам, аналитике и отчетам.